让网站页面内容不被抓取的技巧及方法

在互联网时代,网站的内容被搜索引擎抓取并排名是非常重要的。然而,有时候我们可能希望某些页面的内容不被抓取或者索引,这可能是出于隐私保护、版权保护或其他原因。在本文中,我们将探讨一些让网站页面内容不被抓取的技巧和方法。

(图片来源网络,侵删)

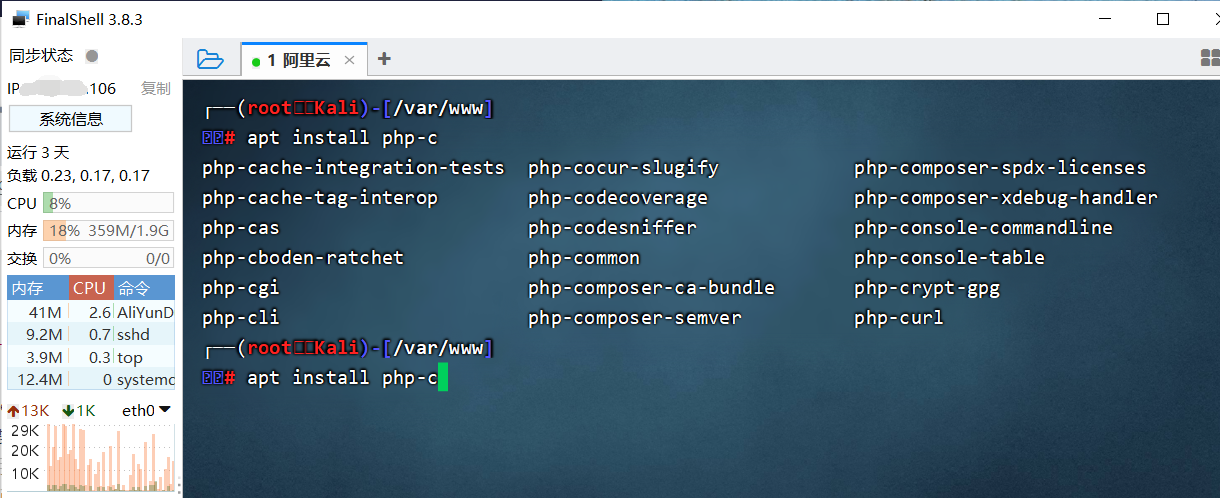

1. 使用robots.txt文件:

robots.txt是一个文本文件,位于网站的根目录下,用于告诉搜索引擎哪些页面可以被抓取,哪些页面不应该被抓取。通过在robots.txt文件中设置Disallow指令,可以阻止搜索引擎抓取特定的页面或目录。

(图片来源网络,侵删)

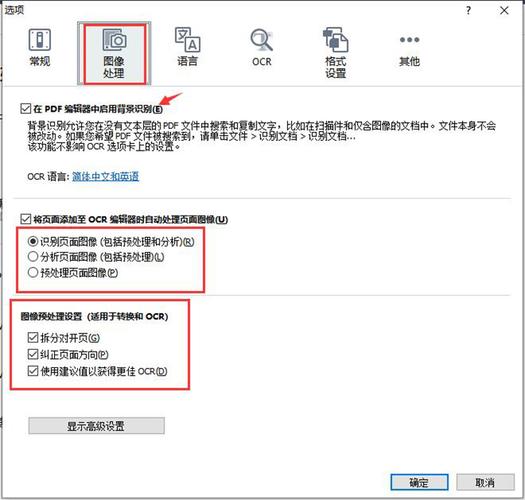

2. 设置meta标签:

在网页的

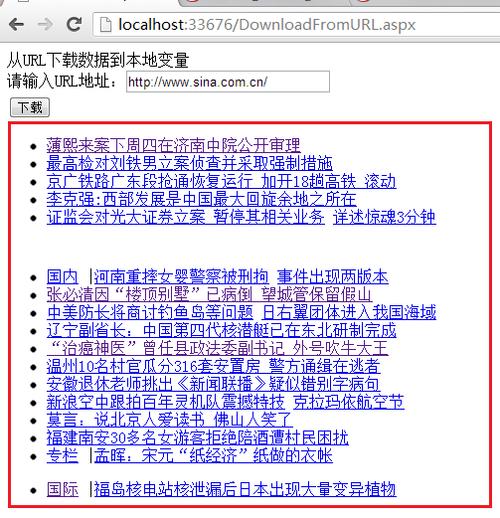

标签中,可以使用meta标签来控制搜索引擎对页面的抓取行为。其中,最常用的是"noindex"和"nofollow"属性。通过设置,可以告诉搜索引擎不要抓取并不要跟踪链接到该页面。3. 使用JavaScript或AJAX加载内容:

如果你希望页面的内容不被简单的爬虫程序所抓取,可以考虑使用JavaScript或AJAX来动态加载内容。这样,只有真正执行JavaScript的浏览器才能看到页面的内容,而爬虫程序通常无法执行JavaScript代码。

4. 验证用户身份:

如果你希望某些页面的内容只对特定的用户或会员可见,可以使用用户身份验证来限制访问。这样,普通的爬虫程序将无法通过验证,无法抓取受限制的内容。

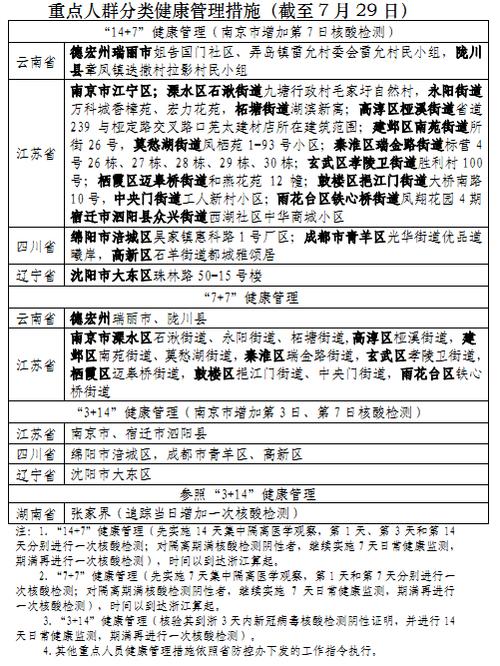

5. 使用图片、视频或Flash等非文本内容:

爬虫程序主要是针对文本内容进行抓取和索引的,因此如果你在页面中使用大量的图片、视频或Flash等非文本内容,这些内容很可能不会被爬虫程序抓取和索引。

综上所述,以上是一些让网站页面内容不被抓取的技巧和方法。根据具体需求,可以选择适合自己的方式来保护网站内容的隐私和安全。