在docker中部署ollama体验AI模型

- 1.docker部署ollama

- 1.1.CPU模式

- 1.2.GPU模式(需要有NVIDIA显卡支持)

- 1.2.1.安装英伟达容器工具包(以Ubuntu22.04为例)

- 1.2.2.docker使用GPU运行ollama

- 2.docker部署ollama web ui

- 3.使用docker中的ollama下载并运行AI模型(示例为阿里通义千问4b-chat)

- 4.ollama模型仓库(可以选择自己想用的模型安装体验)

1.docker部署ollama

1.1.CPU模式

docker run -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

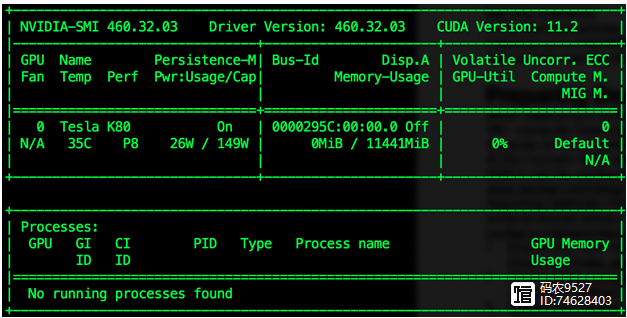

1.2.GPU模式(需要有NVIDIA显卡支持)

1.2.1.安装英伟达容器工具包(以Ubuntu22.04为例)

其他系统请参考:英伟达官方文档

(图片来源网络,侵删)

(图片来源网络,侵删)# 1.配置apt源 curl -fsSL https://nvidia.Github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg \ && curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | \ sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | \ sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list # 2.更新源 sudo apt-get update # 3.安装工具包 sudo apt-get install -y nvidia-container-toolkit

1.2.2.docker使用GPU运行ollama

docker run --gpus all -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

2.docker部署ollama web ui

docker run -d -p 8080:8080 -add-host=host.docker.internal:host-gateway -name ollama-webui -restart always ghcr.io/ollama-webui/ollama-webui:main

3.使用docker中的ollama下载并运行AI模型(示例为阿里通义千问4b-chat)

docker exec -it ollama ollama run qwen:4b-chat

4.ollama模型仓库(可以选择自己想用的模型安装体验)

ollama模型仓库

(图片来源网络,侵删)

(图片来源网络,侵删)