一、说明

在GPT的发展过程中,一篇论文起到至关重要的作用,就是《注意力就是你所需要的一切》,此文奠定了Transformer的概念框架,然后,Trandsformer和生成式框架结合,成为最初的GPT框架。本文再现对注意力机制的理解。

二、介绍“注意力就是你所需要的一切”:人工智能的游戏规则改变者

想象一下,一个不再存在语言障碍的世界——一个来自世界不同角落的人们之间的交流变得无缝的地方。现在,想象一下一个人工智能系统,它可以理解和生成类似人类的文本,促进创新并增强整个数字领域的用户体验。Vaswani 等人的开创性研究论文“Attention Is All You Need”为这一变革性愿景铺平了道路。

这篇论文发表于 2017 年,介绍了 Transformer 架构,该架构后来成为现代自然语言处理 (NLP) 技术的基石。在诞生之前,递归神经网络 (RNN) 及其变体(如 LSTM 和 GRU)是顺序数据处理的首选解决方案。虽然有效,但这些模型也有其局限性,特别是在训练效率和处理数据中的长期依赖关系方面。

输入“注意”的概念。注意力机制不是按顺序处理数据,而是允许模型专注于输入数据的不同部分,为其提供一种“短期记忆”来辨别什么是本质的。这项创新使模型能够以极高的准确性捕获数据中复杂的模式和关系。

三、那么,为什么这篇论文具有里程碑式的重要性呢?

1 后续创新的基础:Transformer 架构构成了 BERT、GPT 和 T5 等模型的基础,这些模型主导了从翻译到文本生成的 NLP 任务。

2 提升 AI 功能:借助 Attention 的强大功能,AI 模型现在可以生成更连贯且与上下文相关的内容。这导致了增强的聊天机器人、改进的搜索引擎和更可靠的语言翻译工具。

3 人工智能的民主化:预训练模型的兴起,其起源归功于 Transformer,这意味着没有大量资源的企业和开发人员现在可以访问最先进的 AI 功能。

随着我们对这个概念的深入研究,我们将揭开“注意力就是你所需要的一切”背后的直觉魔力。我们将探讨这个单一的概念如何产生连锁反应,彻底改变人工智能并建立机器学习的新范式。无论你是人工智能爱好者还是经验丰富的研究人员,理解这篇论文就像见证了技术史上的一个决定性时刻。欢迎来到旅程!

四、注意力机制解释

想象一下,你正在读一本长篇小说,每次你遇到像“他”或“她”这样的代词时,你都会立即想起它指的是前面的段落或章节中的谁。你的大脑不会从头到尾线性地阅读小说来理解每个句子的上下文,而是直觉地“关注”有助于理解当前句子的相关部分。

这种“回溯”或“注意”文本特定部分以进行理解的能力正是 ChatGPT 等神经网络中的注意力机制。

让我们举一个简化的例子:

句子:“李医生喜欢他的狗黛西,经常带她去公园,给她几个”咕噜咕噜”。

如果你想知道“她”指的是谁,你的大脑可能会更多地“关注”“李博士”和“狗黛西”这两个词来推导出上下文。从本质上讲,您根据不同单词的相关性为不同的单词分配不同的“权重”。

4.1 在注意力机制中:

句子中的单词被分配了不同的权重。

这些权重决定了每个单词在尝试预测或理解另一个单词时获得多少焦点或“注意力”。

4.2 连接到 ChatGPT:

ChatGPT 与其他基于 Transformer 的模型一样,利用了这种注意力机制。当您提出问题时,模型不会孤立地查看您当前的信息。它“关注”整个对话上下文的各个部分,根据相关性为不同部分分配权重。此功能可帮助模型生成相关且上下文适当的响应。

因此,就像你的大脑关注我们例句中的特定单词来理解“她”的引用一样,ChatGPT 也会关注对话的不同部分以提供连贯的回复。

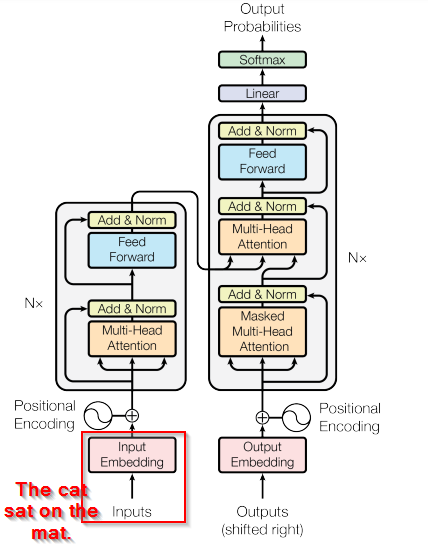

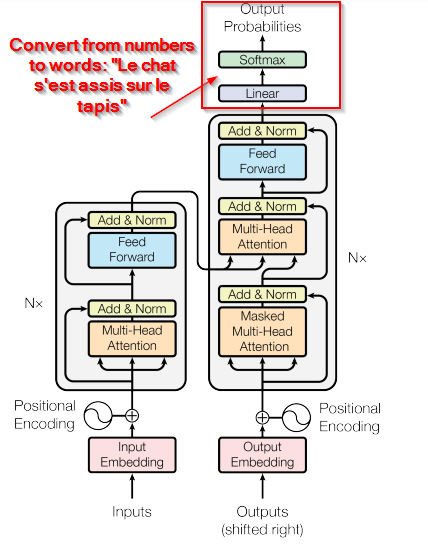

五、示例:将“The cat sat on the mat”翻译成法语“Le chat s’est assis sur le tapis”

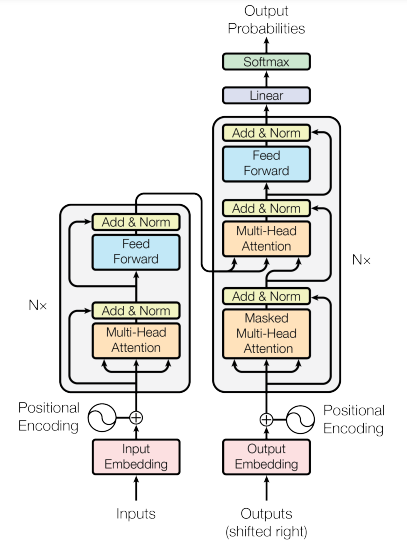

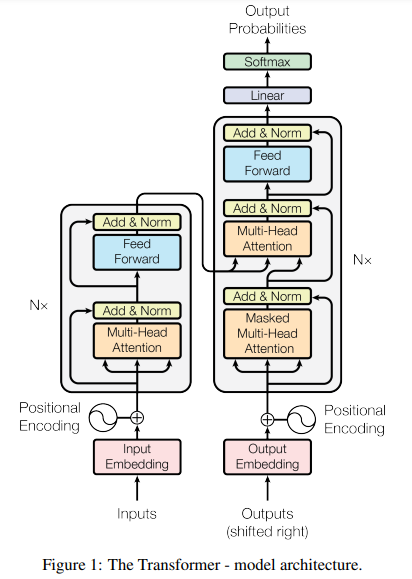

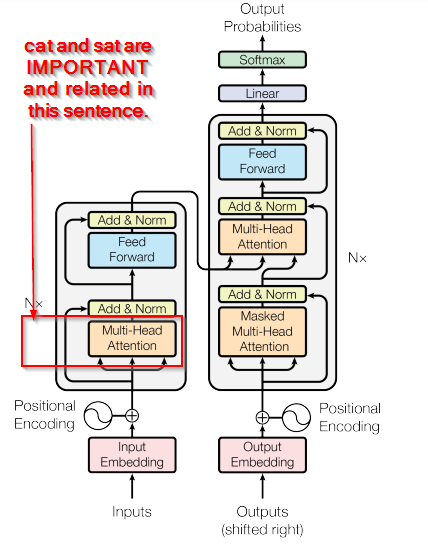

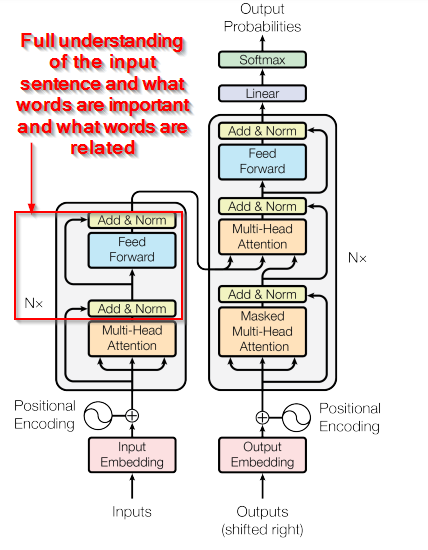

让我们直接使用这篇开创性论文中的架构图来分解这一点:

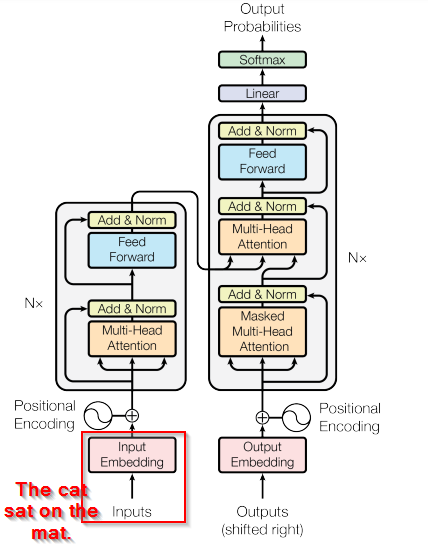

5.1 输入嵌入和源语句:

你输入句子“猫坐在垫子上”。

该模型首先通过称为“嵌入”的过程将这些单词转换为数值向量。

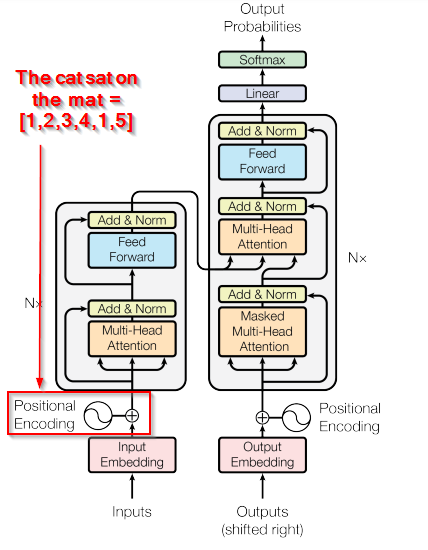

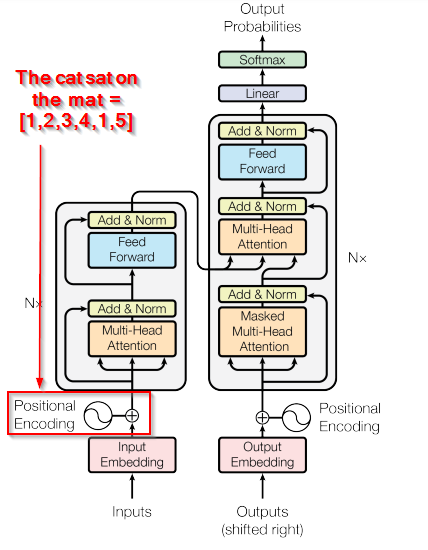

5.2 位置编码:

由于转换器本身并不理解单词的顺序,因此此步骤会添加有关每个单词在句子中的位置的信息。因此,“猫”这个词可能会得到一些位置信息,表明它是第二个词。

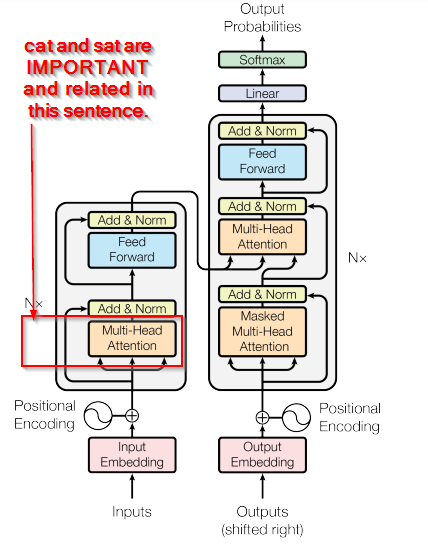

5.3 多头注意力(左侧):

这是一个神奇的步骤,模型可以找出句子中的哪些单词是重要的并且彼此相关。在这里,它可能会认识到“猫”与“坐”密切相关(因为猫是坐着的人)。

5.4 添加 & 规范:

应用注意力后,模型将对数据进行规范化,确保其格式易于模型使用。

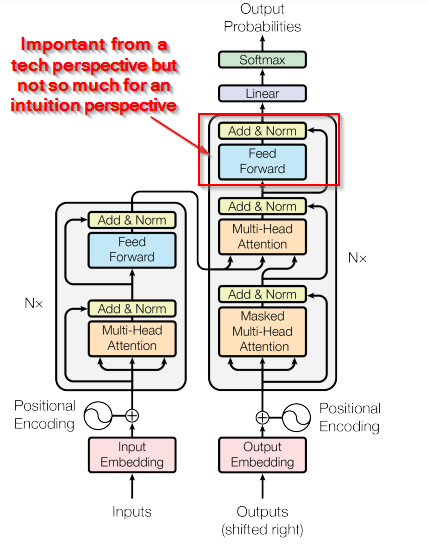

六、关于反馈

这只是一个简单的神经网络,对数据进行进一步的转换。

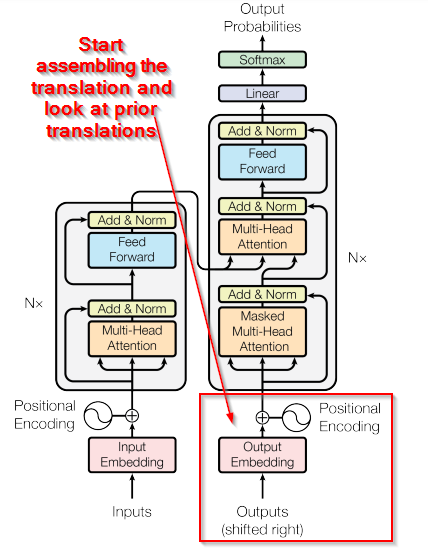

现在,在右侧,这是解码器:

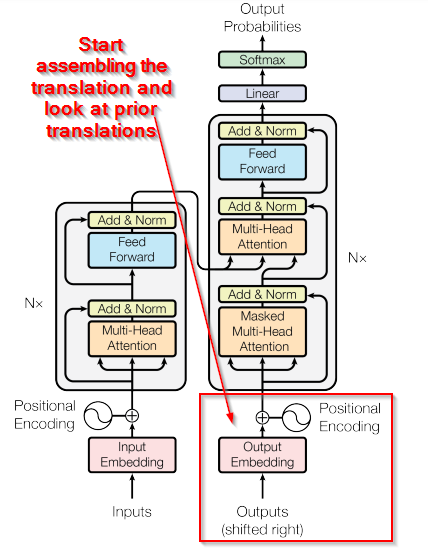

6.1 输出嵌入、输出句子:

解码器通过查看任何先前的翻译来开始其过程。最初,它可能只是一个指示翻译开始的起始标记。

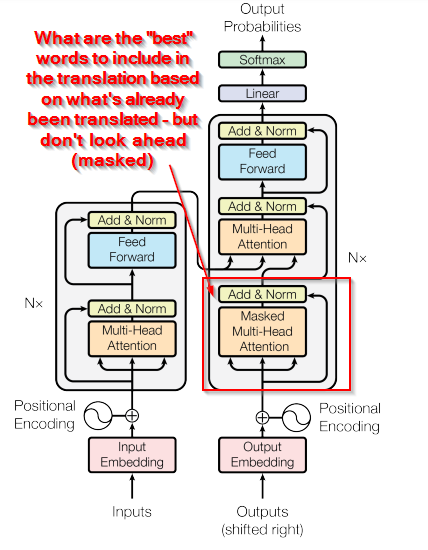

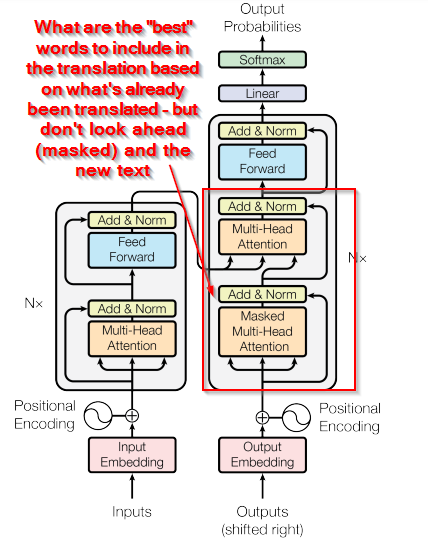

6.2 带屏蔽的多头注意力

解码器会注意先前翻译的单词。这是“屏蔽”的,以确保模型不会提前查看它不应该知道的未来单词。

6.3 多头注意力(右侧):

现在,解码器也会关注编码器的输出,试图找出接下来要翻译的最佳单词。因此,它可能会查看“猫”并决定下一个法语单词应该是“聊天”。

6.4 添加 & 规范:

同样,数据被归一化。

6.5 前馈:

神经网络进行转换。

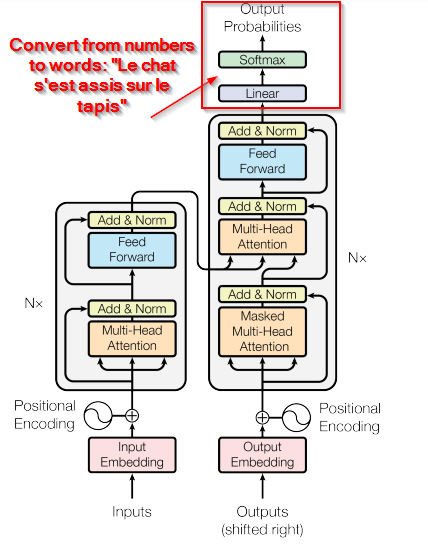

线性 & Softmax:

这些步骤将解码器的内部数据转换回实际单词。完成此操作后,模型可能会输出单词“chat”作为“cat”的翻译。

这个过程对每个单词继续进行,直到生成完整的句子“Le chat s’est assis sur le tapis”。

请记住,这是一个非常简化的示例。实际上,该模型同时考虑了许多可能的翻译,并使用复杂的数学来选择最佳单词。但这应该让你对翻译句子时数据如何流经转换器有一个基本的了解!

七、奖励:一个更直观的解释:

想象一下教机器人翻译

你希望你的机器人将“猫坐在垫子上”这句话翻译成另一种语言。但它是如何做到的呢?让我们使用原始论文中的架构图来演练这些步骤:

7.1 输入句子:

- 发生了什么?你将这句话输入机器人。

- 图像指南:查看左下角的“输入”框。

- 简单的类比:将此视为给机器人一个需要解决的难题。

7.2 理解单词位置:

- 发生了什么事情?机器人用数字标记每个单词以了解其位置。

- 图像指南:这是“位置编码”框。

- 简单的类比:这就像用数字标记每个拼图,这样你就知道它适合哪里。

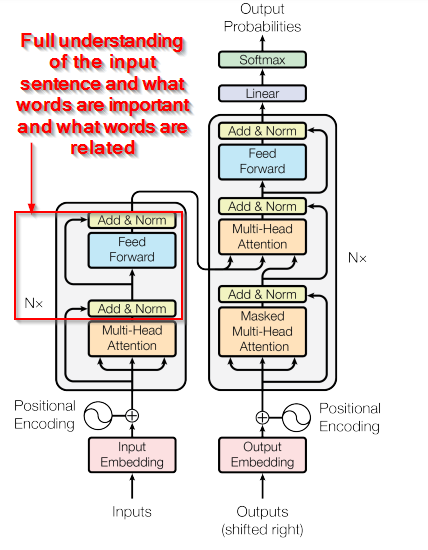

7.3 决定单词重要性:

- 发生了什么事情?机器人确定哪些单词与他人更相关或更重要。

- 图像指南:这是左侧的“多头注意力”部分。

- 简单的类比:想象一下,机器人用手电筒将更亮的光照在重要的拼图上,使它们更容易看到和拼接在一起。

7.4 平滑事情:

发生了什么事情?机器人确保一切都是平衡和有序的。

- 图像指南:“添加和规范”和“前馈”部分。

- 简单的类比:放置一些拼图后,机器人将它们平滑,以确保它们完美贴合。

现在,机器人已经理解了你的句子。是时候翻译它了。

7.5 开始翻译:

- 发生了什么事情?机器人开始逐字翻译。

- 图像指南:检查右下角的“输出嵌入”部分。

- 简单的类比:机器人开始使用旧谜题的线索组装新谜题。

7.6 选择正确的词语:

- 发生了什么事情?机器人使用原文和迄今为止翻译的内容的线索来决定最佳翻译词。

- 图像指南:这是“蒙面多头注意力”和右边的“多头注意力”。

- 简单的类比:想想机器人偷看拼图盒上的图片以寻找提示。

7.7 最后润色:

- 发生了什么事情?机器人完成翻译。

- 图像指南:顶部的“线性和Softmax”部分。

- 简单的类比:放置最后一块拼图,揭示全貌。

最后,您的机器人将“猫坐在垫子上”翻译成另一种语言的句子,确保每个单词都完美地适合它的新位置。

八、结论

生成式人工智能的奇迹,就像组装拼图游戏的复杂过程一样,取决于对细节的仔细关注和对大局的理解。通过在翻译句子和拼凑谜题之间画出相似之处,我们解开了图像中描绘的模型的复杂工作原理。通过分步分解,可以一窥这些生成式 AI 系统所采用的细致方法。

理解这种直觉至关重要,原因如下:

1) 揭开人工智能的神秘面纱:简化复杂的机制使人工智能更容易为公众所接受,消除“魔力”并揭示其背后的结构化逻辑。

2)明智的决策:掌握基本原则有助于企业、开发人员和用户对人工智能的应用和潜力做出更明智的决策。

3)培养信任:知识产生信任。当人们理解人工智能的工作原理时,即使是在基本层面上,他们也更有可能信任并负责任地使用它。

4)刺激创新:当更多的人理解核心概念时,它就为创新铺平了道路,从而为生成式人工智能带来更先进和量身定制的应用。

从本质上讲,正如理解拼图的细微差别有助于拼凑出一幅连贯的画面一样,理解人工智能的基本原理为利用其全部潜力奠定了基础。随着人工智能继续渗透到我们生活的方方面面,这种理解将成为开启人类和机器和谐共处的未来的关键,每个人都能放大对方的优势。