AI人工智能核心算法原理与代码实例讲解:算法偏见

1.背景介绍

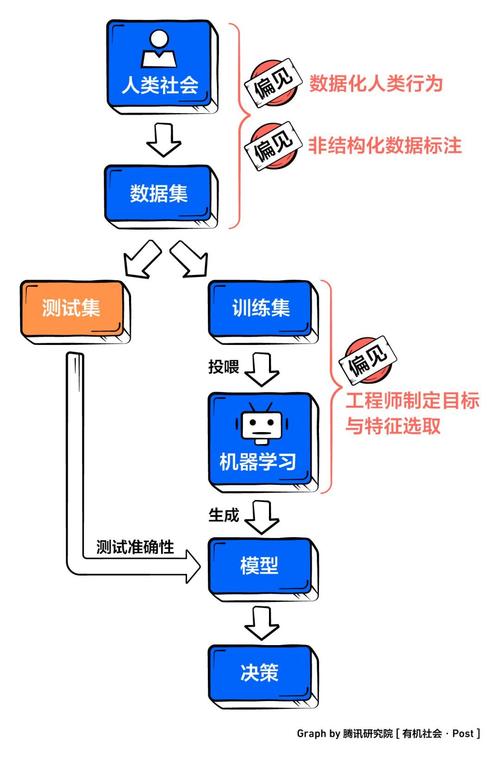

在当今数字时代,人工智能(AI)已经无处不在,从网络搜索到金融服务,再到医疗诊断等各个领域。然而,近年来人们越来越关注AI系统中潜在的算法偏见问题。算法偏见指的是,由于训练数据或模型本身的缺陷,导致AI系统在做出决策时表现出对某些群体的不公平对待。

(图片来源网络,侵删)

算法偏见不仅会影响AI系统的公平性和准确性,也可能加剧社会中已有的歧视和不平等。例如,一些人脸识别系统对于识别非裔美国人和亚裔人的准确率较低;某些招聘AI在筛选简历时,可能会对女性求职者产生偏见。因此,消除算法偏见,构建公平、可靠、可解释的AI系统,是当前AI研究和应用的一个重要课题。

2.核心概念与联系

要理解算法偏见的成因及其消除途径,我们需要掌握以下几个核心概念:

(图片来源网络,侵删)

2.1 表征偏差

表征偏差(Representation Bias)指的是,AI系统使用的特征无法很好地代表不同群体,从而导致对某些群体的决策表现不佳。例如,一个语音识别系统如果主要使用英语作为训练数据,那么对于非英语母语者的语音识别准确率可能会较低。

2.2 样本偏差

样本偏差(Sample Bias)指的是,AI系统的训练数据本身存在偏差,不能很好地代表整个目标人群。例如,如果一个面部表情分类模型的训练数据主要来自于中年白人男性,那么对于其他人群的表情识别准确率可能会较低。

2.3 算法偏差

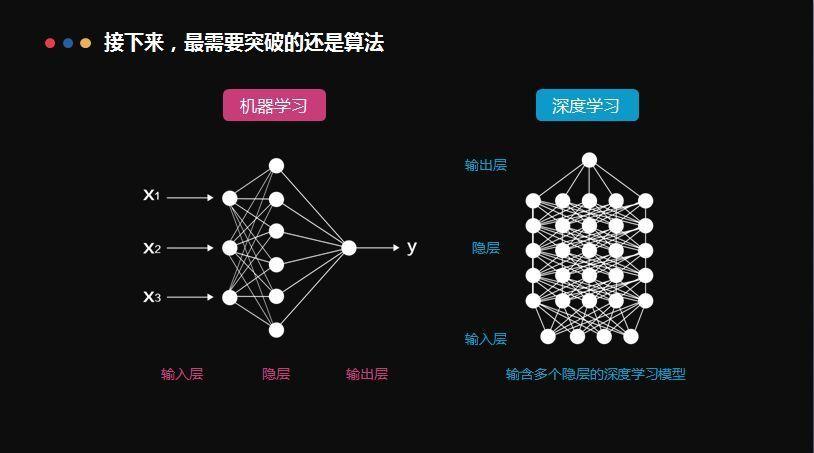

算法偏差(Algorithmic Bias)指的是,即使训练数据没有明显的偏差,但由于算法本身的缺陷,也可能导致AI系统对某些群体产生不公平的决策。例如,某些聚类算法可能会过度将少数群体样本聚类到同一簇。

2.4 人为偏差

人为偏差(Human Bias)指的是,由于设计者或使用者本身的偏见,导致AI系统产生不公平的结果。例